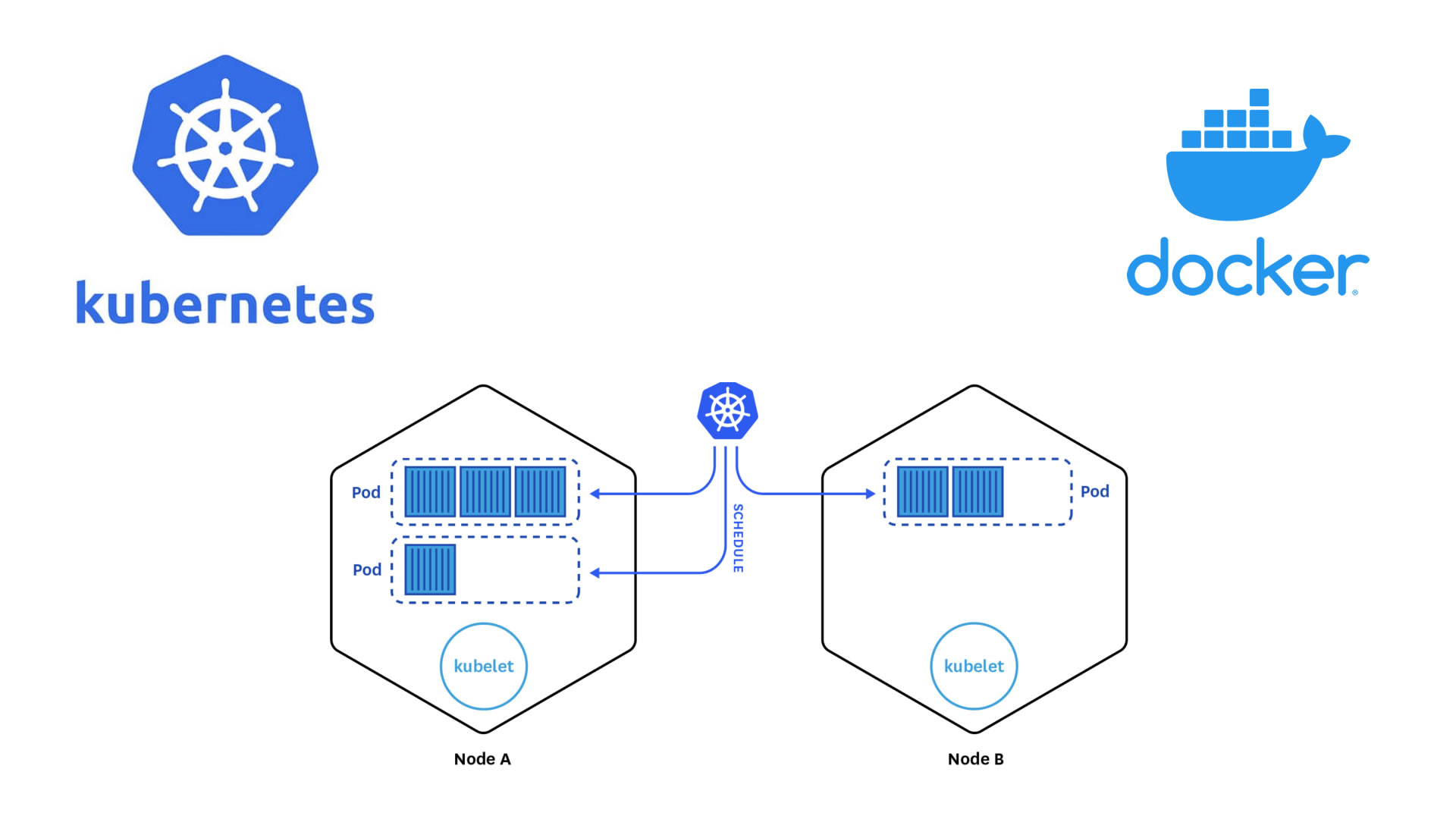

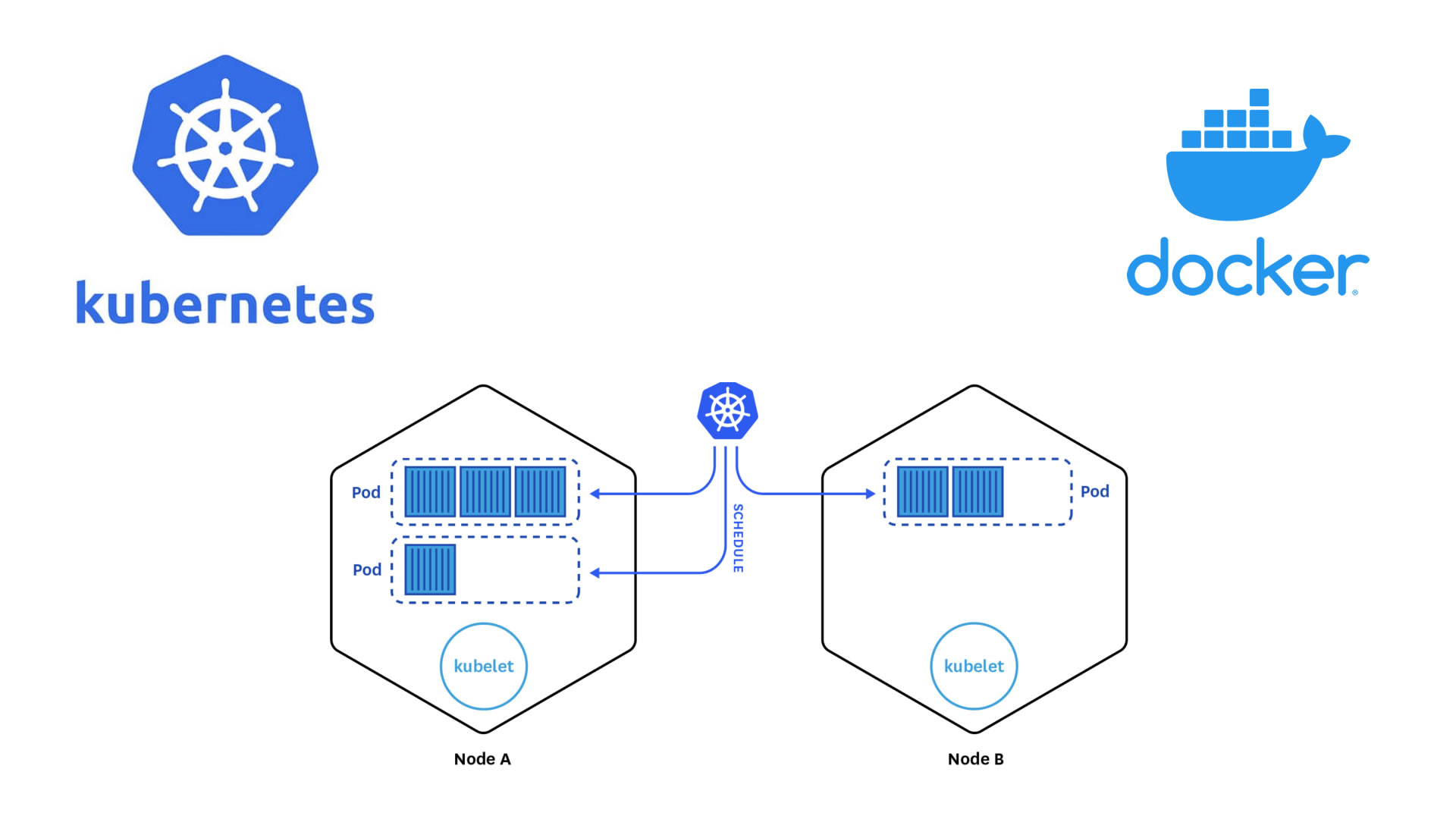

Tutorial: ¿Cómo instalar tu primer Cluster de Kubernetes?

Kubernetes te permite orquestar tus containers de manera muy sencilla

Published on May 10, 2020

/ Author: Rafael Escalante

kubernetes

containers

docker

orchestration

Published on May 10, 2020

/ Author: Rafael Escalante

kubernetes

containers

docker

orchestration